本地部署

本地部署模型对电脑显卡要求都比较高,至少建议N卡3060以上,若对翻译质量要求较高,自己电脑配置不够高,也可以花一些钱试试租用显卡方案

Sakura本地翻译模型说明

本翻译源需要较强电脑方面的动手能力,需要至少8G显存以上的显卡(30系显卡及以上),不推荐所有人使用

- Sakura是模型的名称,还需要启动器才可以运行,可选的启动器有两种,llama启动器和tgw启动器],任选一种就行,比较推荐llama启动器

- Sakura开源的语言聊天模型,类比的话就是gpt聊天模型,翻译器只是通过prompt将其变为了翻译源

- 一般来讲,模型的后缀数字越大(如7b和13b),对显存要求越高,翻译质量也会更好,sakura—13b的模型能近似与gpt3.5的翻译质量,但同时要求显卡有14G以上显存;显卡弱一些的也可以试试GalTransl-7B模型,需要8G显存,针对galgame单独做过优化,在翻译效果上也很不错

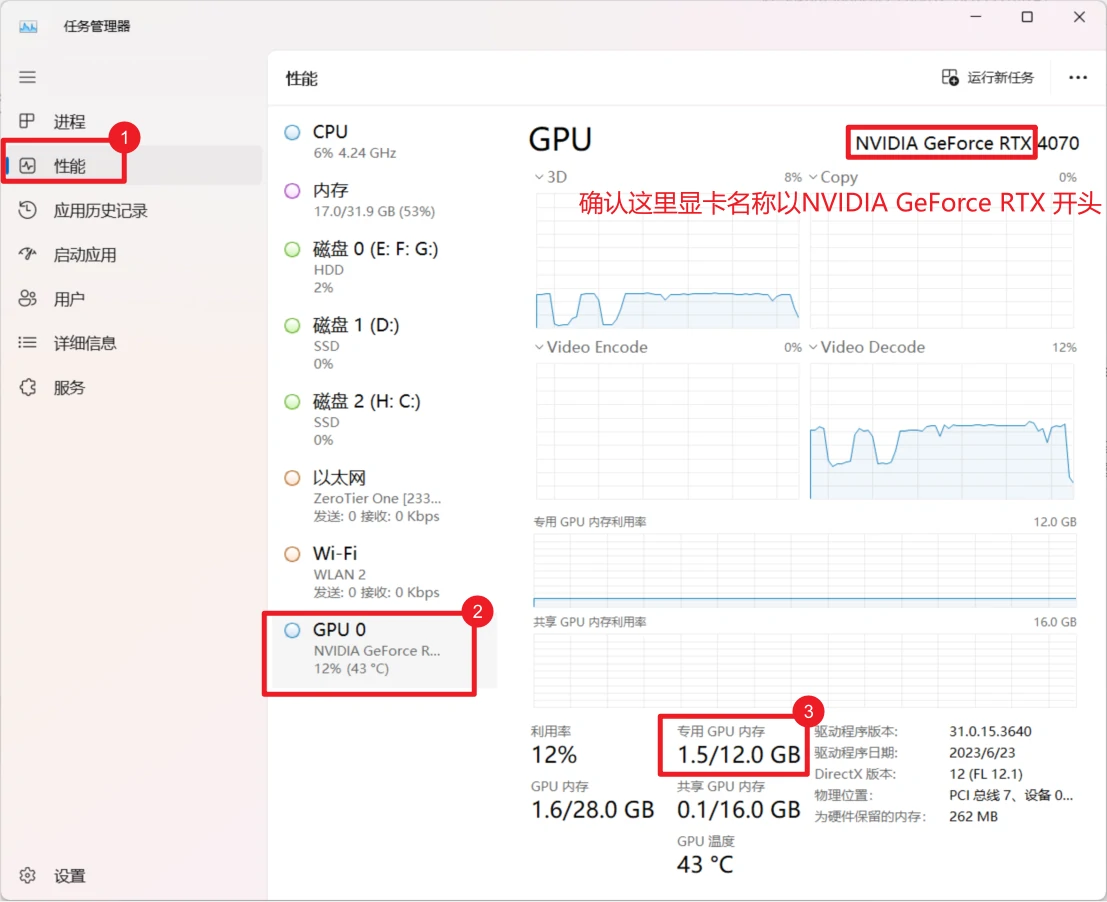

查看电脑是否支持运行本地翻译模型

在系统任务栏底部右键,点击

任务管理器

点击

性能,GPU0(如果存在多个GPU,选择更下面的那个),查看专用GPU内存大小,如图为12G显存,就满足了模型运行要求的最低8G显存,否则不建议使用本地翻译模型,请更换其他在线翻译源- 同时确认下右上角名称是否为

NVIDIA GeForce RTX开头,即显卡是N卡才能运行,如果是A卡(AMD显卡)或核显,模型无法运行

- 同时确认下右上角名称是否为

Sakura(llama)教程

确认电脑支持运行本地翻译模型;

下载llama启动器,在下列下载链接中选择一个打开,并下载其中的

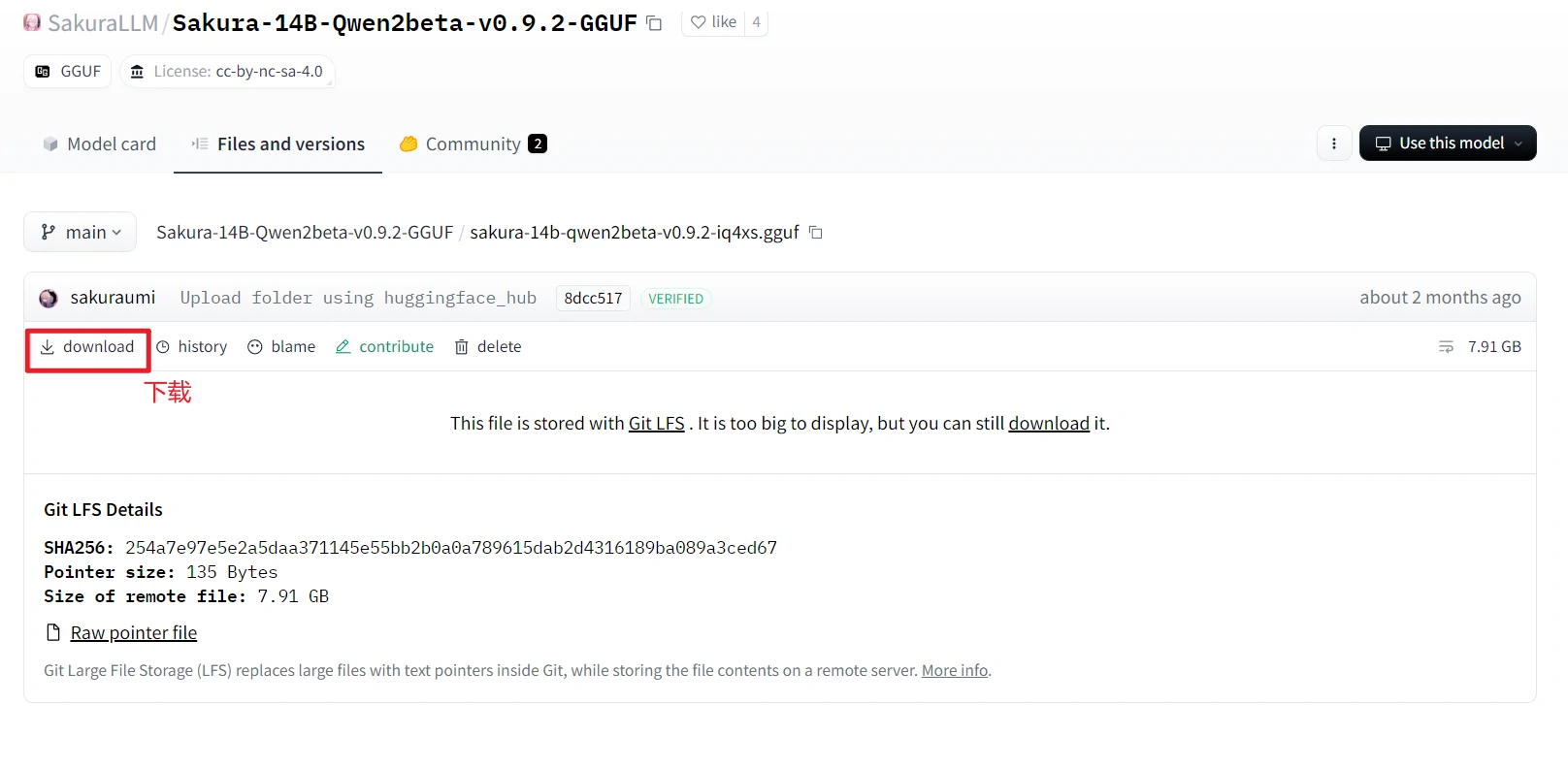

sakura-launcher-cuda12-b2859.zip文件接下来需要下载模型文件,根据你要翻译的内容是日文还是英文选择对应的模型(其他小语种暂不支持),然后根据显存大小下载其中一种模型就行

sakura系列模型,只支持日语sakura-7b-lnovel-v0.9-Q4_K_M.gguf模型,运行需要至少8g显存sakura-14b-qwen2beta-v0.9.2-iq4xs.gguf模型,运行需要至少12g显存

qwen系列模型,只支持英文qwen-1.5-7b-chat-q8_0.gguf模型,运行需要至少8g显存qwen-1.5-14b-chat-q8_0.gguf模型,运行需要至少12g显存

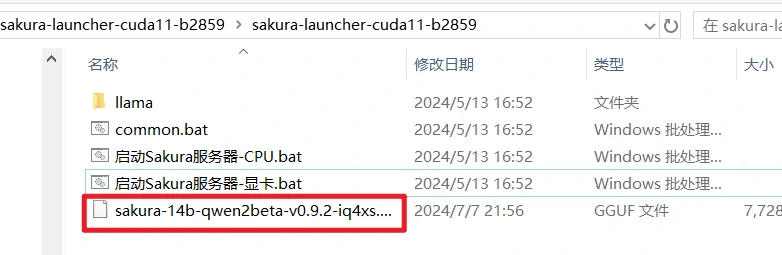

- 模型文件下载后,将其放在llama启动器解压后的

sakura-launcher开头的文件夹内,如sakura-launcher-cuda11-b2859文件夹内

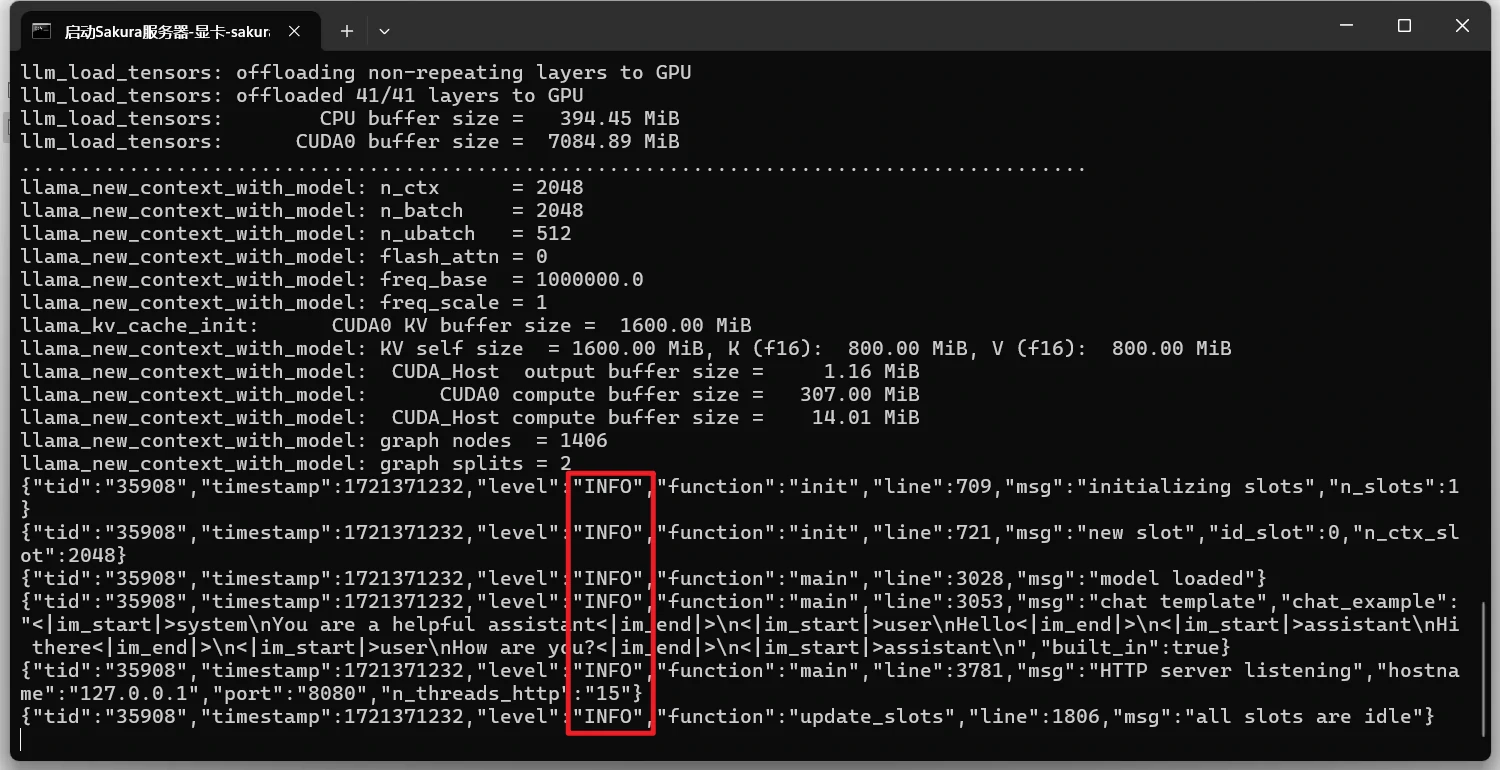

- 双击该文件夹下的

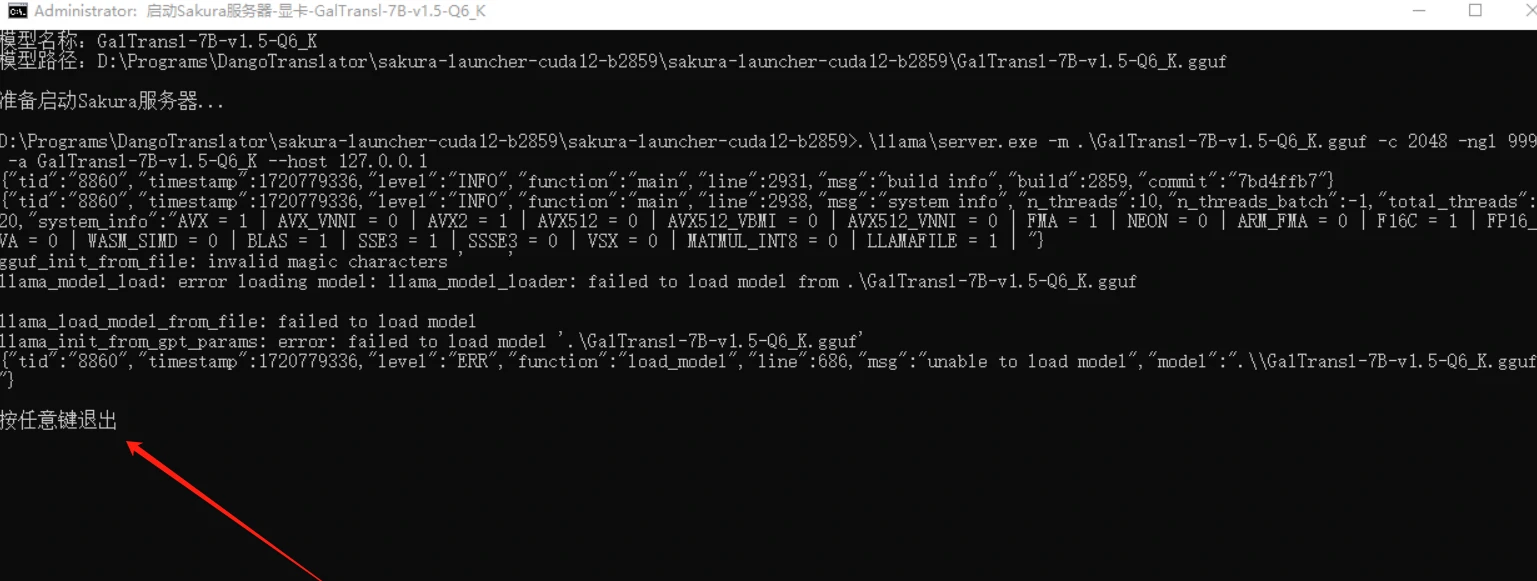

启动Sakura服务器-显卡.bat开始运行模型,会打开一个黑窗 - 打开黑窗后5s左右,黑窗开始输出包含

info的文本,说明已经成功运行,最小化此黑窗后,再回到翻译器界面

- 如果显示了

请按任意键退出,说明运行失败了,可能是显卡显存不够用,请更换其他在线翻译源或显存要求更低的模型

在Sakura(llama)的

设置这里,也可以将上述的启动Sakura服务器-显卡.bat添加至模型启动器位置,更方便打开模型点击Sakura(llama)的

测试,看模型是否运行成功(如下图),测试成功后再打开该翻译源接口

- 若提示测试出错,可截图Sakura模型运行的黑色窗口,并发送到用户群寻求帮助

Sakura(tgw)教程

部署和安装教程很长,具体可参考tgw部署视频

确认tgw完成部署并运行模型后,点击测试,看能否正常运行